實測:頂級AI模型未達到歐盟AI法案標準

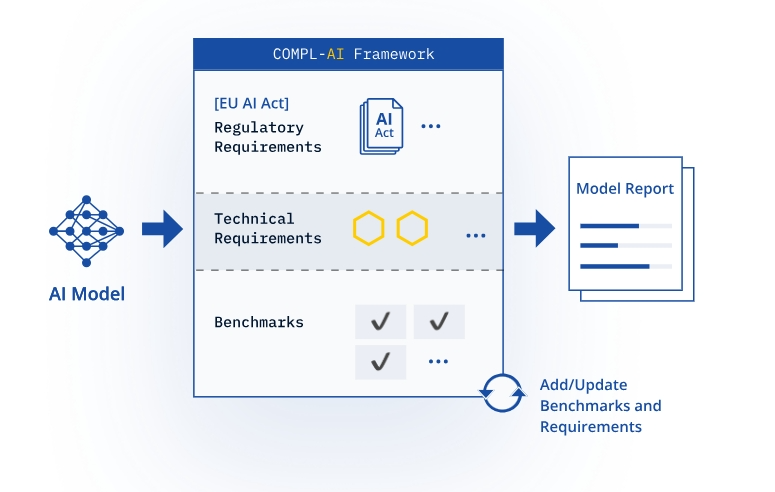

責編:gltian |2024-10-17 16:26:59瑞士初創公司LatticeFlow開發了名為“COMPL-AI”的大型語言模型測試工具(LLM Checker),旨在測試AI模型是否能滿足歐盟人工智能法案的合規性要求,該工具受到歐盟官員的廣泛歡迎。測試結果顯示,一些頂級科技公司的人工智能模型在網絡安全和防止歧視性輸出等關鍵領域未能達到要求。

一、測試結果

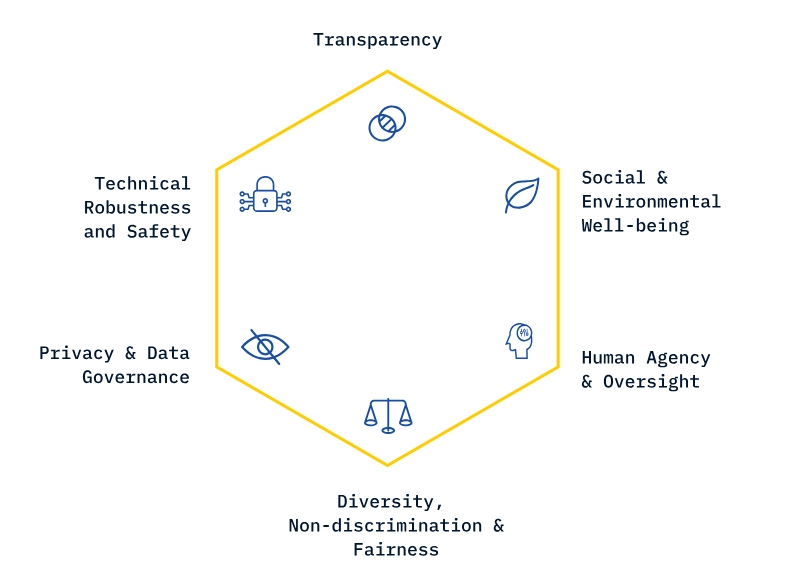

該工具由LatticeFlow與蘇黎世聯邦理工學院和保加利亞計算機科學、人工智能和技術研究所合作設計,從技術穩健性和安全性,隱私和數據治理,透明度,多元化、非歧視和公平,社會與環境福祉,人類的主體性與監督等方面測試了OpenAI、Meta、阿里巴巴等頂級科技公司的AI模型。

這些模型的測試分數從0到1不等,大多數測試的模型平均得分為0.75或更高,例如Anthropic的“Claude 3 Opus”得分為0.89。但在測試中,一些模型也暴露了重大缺陷。

在測試歧視性輸出時,OpenAI的“GPT-3.5 Turbo”獲得了0.46的低分,而阿里巴巴的“Qwen1.5 72B Chat”得分更低,為0.37,凸顯了人工智能在性別和種族等領域反映人類偏見的問題。

在測試“提示劫持”時(一種黑客使用欺騙性提示來提取敏感信息的攻擊形式),Meta的Llama 2 13B Chat模型得分為0.42,而法國初創公司Mistral的8x7B Instruct模型得分為0.38。

二、未來展望

LLM Checker的開發是為了與歐盟人工智能法案不斷變化的要求保持一致,隨著未來兩年執法措施的出臺,該工具預計將發揮更大的作用。LatticeFlow已免費提供該工具,允許開發人員在線測試其AI模型的合規性,讓他們了解滿足歐盟AI法案要求時面臨的挑戰。此外,法案的部分要求預計將于2025年全面實施,不遵守AI法案的公司將面臨3500萬歐元(3800萬美元)或其全球年營業額7%的罰款。

LatticeFlow公司的首席執行官兼聯合創始人Petar Tsankov表示,測試結果總體上是積極的,能為各公司提供一個路線圖,供他們根據法案微調模型。

歐盟委員會也一直在密切關注該工具的發展,一位發言人表示,該工具代表了將歐盟人工智能法案轉化為技術合規要求的“第一步”,這表明更詳細的執法措施正在計劃中。